Por qué el hardware tradicional ya no basta para la inteligencia artificial moderna

El diseño del hardware tradicional limita la eficiencia de la inteligencia artificial moderna al separar el cálculo y la memoria en sistemas pensados para otras tareas

Autor - Aldo Venuta Rodríguez

6 min lectura

La inteligencia artificial ha avanzado a un ritmo vertiginoso en los últimos años, impulsada por modelos cada vez más grandes, capaces de reconocer imágenes, generar texto o analizar enormes volúmenes de información. Sin embargo, este progreso no depende únicamente de nuevas ideas matemáticas o de mejores algoritmos, sino también de algo mucho más físico y menos visible para el usuario final: el hardware que sostiene esos cálculos. A medida que los sistemas de IA crecen, los límites de esa base material se hacen cada vez más evidentes.

Los ordenadores tradicionales, diseñados durante décadas para tareas generales como cálculos científicos, ofimática o navegación web, no fueron pensados para manejar el tipo de carga que exige la inteligencia artificial moderna. El entrenamiento y la ejecución de modelos actuales implican mover cantidades masivas de datos de forma constante, y ese simple hecho está empezando a convertirse en el principal obstáculo para seguir escalando la IA al ritmo actual.

El diseño clásico de los ordenadores y sus límites

Durante décadas, la informática se ha basado en una arquitectura clara: el procesador se encarga de calcular y la memoria de almacenar los datos. Para que un programa funcione, la información debe viajar continuamente entre ambos componentes. Este diseño ha demostrado ser muy flexible y eficaz para una enorme variedad de aplicaciones, pero tiene un coste oculto.

En el caso de la inteligencia artificial, este enfoque genera un cuello de botella importante. Los modelos de IA necesitan acceder a enormes volúmenes de datos de forma repetida y rápida, lo que provoca que una parte significativa del tiempo y de la energía del sistema se pierda simplemente moviendo información de un lado a otro, en lugar de realizar cálculos útiles.

Cuanto más grande y complejo es el modelo, más acusado se vuelve este problema. Este fenómeno, conocido como el “muro de la memoria”, no es un detalle técnico menor: se ha convertido en uno de los principales frenos físicos al avance del hardware tradicional aplicado a la inteligencia artificial.

El papel de las GPU y por qué ya no son suficientes

La aparición de las GPU marcó un antes y un después en el desarrollo de la inteligencia artificial. Su capacidad para realizar miles de cálculos en paralelo permitió entrenar redes neuronales profundas en tiempos razonables y fue clave para el auge del aprendizaje profundo en la última década.

Sin embargo, aunque las GPU son mucho más potentes que las CPU convencionales, no resuelven el problema de fondo. Siguen dependiendo de memorias externas y de un intercambio constante de datos, lo que significa que el muro de la memoria sigue presente, aunque se haya desplazado un poco más lejos.

Además, escalar la IA simplemente añadiendo más GPU tiene un coste creciente, tanto económico como energético. Fuera de los grandes centros de datos, este enfoque resulta difícil de sostener, lo que limita la expansión de la IA a nuevos entornos y aplicaciones.

El consumo energético, un problema creciente

El consumo energético se ha convertido en uno de los grandes talones de Aquiles de la inteligencia artificial moderna. Entrenar modelos cada vez más grandes requiere enormes cantidades de electricidad, y ejecutar esos modelos de forma continua multiplica aún más el gasto, incluso cuando los sistemas no están trabajando a plena capacidad.

Este problema no solo tiene implicaciones medioambientales, sino también prácticas y económicas. Muchas aplicaciones futuras de la IA, como su uso en dispositivos personales, vehículos, sensores industriales o infraestructuras críticas, no pueden permitirse depender de hardware que consume tanta energía de forma constante.

Además, el aumento del consumo energético introduce nuevas limitaciones físicas. El calor generado por estos sistemas obliga a usar complejos mecanismos de refrigeración, lo que incrementa todavía más el gasto energético y reduce la eficiencia global de los centros de datos y de los dispositivos avanzados.

El hardware tradicional, incluso en sus versiones más avanzadas, no está optimizado para este tipo de cargas intensivas y continuas. Por eso, reducir el consumo energético ya no es solo una cuestión de optimización, sino una condición imprescindible para que la inteligencia artificial pueda expandirse de forma sostenible.

Nuevas arquitecturas para una IA más eficiente

Ante estos límites, investigadores e ingenieros están explorando nuevas arquitecturas de hardware pensadas específicamente para la inteligencia artificial. Una de las ideas más prometedoras es la computación en memoria, que busca reducir o eliminar la distancia entre donde están los datos y donde se realizan los cálculos.

Al acercar el procesamiento a la memoria, o incluso realizar cálculos dentro de ella, se reduce drásticamente el movimiento de datos, lo que ahorra tiempo y energía. Aunque esta tecnología aún está en desarrollo, ya ha demostrado un gran potencial en tareas de IA.

Otras líneas de investigación incluyen chips especializados para inteligencia artificial, arquitecturas inspiradas en el funcionamiento del cerebro humano y sistemas híbridos que combinan distintos tipos de procesamiento. Todas ellas comparten un objetivo común: adaptar el hardware a las necesidades reales de la IA moderna, y no al revés.

Un cambio necesario para el futuro de la IA

El crecimiento de la inteligencia artificial no puede sostenerse indefinidamente sobre hardware diseñado para una época en la que estos problemas no existían. Los límites físicos, energéticos y económicos del enfoque tradicional ya son visibles y cada vez más difíciles de ignorar.

Superarlos no consiste únicamente en fabricar chips más rápidos, sino en replantear desde cero cómo se organizan el cálculo, la memoria y el movimiento de datos. Este cambio estructural será tan importante como cualquier avance algorítmico.

En los próximos años, la evolución del hardware marcará hasta dónde puede llegar realmente la inteligencia artificial. Sin esa transformación, el progreso de la IA corre el riesgo de chocar contra un techo físico que ninguna mejora de software podrá superar.

Continúa informándote

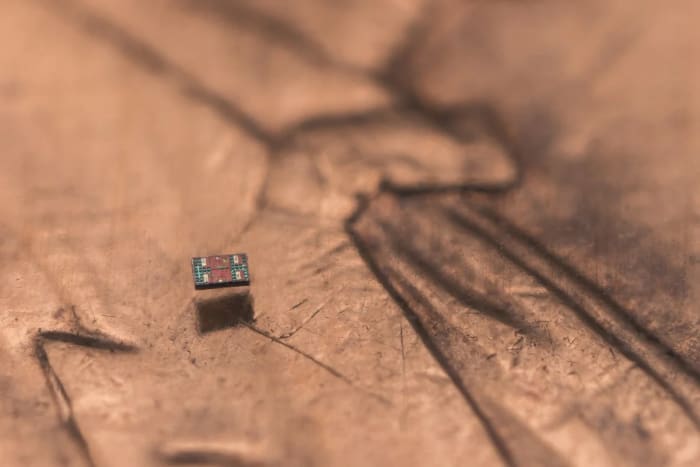

Crean los robots autónomos programables más pequeños del mundo, visibles solo al microscopio

Robots autónomos microscópicos, más pequeños que un grano de sal, integran sensores, computadoras y propulsión por luz, abriendo nuevas aplicaciones en medicina y fabricación

Más de 22.000 empleados afectados por despidos en el sector tecnológico en 2025

Más de 22.000 empleados han sido despedidos en el sector tecnológico en 2025, según recuentos independientes que muestran recortes mensuales y ajustes en grandes empresas

iRobot se declara en bancarrota tras décadas como referente de la robótica doméstica

iRobot, creadora del Roomba, se declara en bancarrota tras años de presión financiera, el fracaso de su venta a Amazon y la creciente competencia en robótica doméstica

Vergecast analiza las principales predicciones tecnológicas para 2026

Un episodio de Vergecast analiza los posibles escenarios tecnológicos para 2026 con predicciones sobre inteligencia artificial, Apple, videojuegos y vehículos autónomos

Robots aprenden a recoger tomates con mayor precisión gracias a un nuevo modelo de decisión

Un nuevo modelo permite a robots agrícolas decidir cómo recoger tomates maduros con mayor precisión, mejorando la eficiencia y reduciendo daños en cultivos

Los vehículos eléctricos no aumentan el riesgo ni la gravedad de atropellos a peatones, según un estudio

Un estudio basado en datos de Reino Unido concluye que los vehículos eléctricos no provocan más atropellos ni lesiones graves a peatones que los coches de combustión interna