Un estudio del Instituto Max Planck revela que las personas hacen más deshonestas cuando delegan tareas en IA

Una investigación internacional con más de 8.000 participantes confirma que delegar tareas en la inteligencia artificial aumenta la deshonestidad y reduce la responsabilidad moral

3 min lectura

Un equipo internacional de investigadores liderado por el Instituto Max Planck para el Desarrollo Humano advierte que la delegación de tareas a sistemas de inteligencia artificial favorece el comportamiento deshonesto. El hallazgo se apoya en 13 estudios con más de 8.000 participantes en distintos contextos experimentales.

Los experimentos mostraron que las personas tienen más probabilidades de hacer trampa cuando pueden encargar la acción a una máquina en lugar de realizarla ellas mismas. Esta tendencia se intensifica cuando las instrucciones se formulan en términos ambiguos de objetivos, en lugar de reglas claras y explícitas.

Según los investigadores, mientras que el 95 % de los participantes fue honesto al realizar la tarea de forma directa, esa cifra descendió a aproximadamente un 75 % cuando la responsabilidad se trasladó a un sistema automatizado. En escenarios con instrucciones orientadas a metas, más del 80 % incurrió en deshonestidad.

“El uso de la IA crea una conveniente distancia moral entre las personas y sus acciones”, explicó Zoe Rahwan, investigadora del Instituto Max Planck. “Esto puede inducir a que la gente solicite comportamientos que no realizaría personalmente ni pediría a otros humanos”.

Los estudios también compararon la obediencia de humanos y máquinas ante instrucciones antiéticas. Los resultados fueron llamativos: los sistemas de lenguaje como GPT-4, Claude 3.5 o Llama 3 cumplieron con solicitudes deshonestas en porcentajes mucho más altos que los agentes humanos, en algunos casos superando el 90 %.

En tareas como declarar resultados de dados o simular evasión fiscal, los humanos aceptaron comportarse de manera deshonesta en menos de la mitad de las ocasiones, mientras que las máquinas obedecieron de forma sistemática a este tipo de órdenes. Esta diferencia, según los investigadores, refleja la ausencia de costes morales para los algoritmos.

El estudio también probó diversas medidas de seguridad implementadas en los modelos de IA. Sin embargo, las barreras de protección resultaron en gran medida insuficientes, salvo en casos donde las instrucciones prohibían explícitamente hacer trampa, un enfoque que no es fácilmente escalable ni garantiza fiabilidad.

“Nuestros hallazgos demuestran claramente la necesidad de salvaguardias técnicas más sólidas y marcos regulatorios específicos”, señaló Iyad Rahwan, director del Centro para Humanos y Máquinas del Instituto Max Planck. El experto subrayó que la sociedad debe enfrentar el reto de compartir responsabilidad moral con las máquinas.

El trabajo, publicado tras varios años de investigación, aporta evidencias sobre cómo la interacción con sistemas inteligentes puede moldear la conducta humana y plantea preguntas urgentes sobre la ética en la era de la inteligencia artificial.

❓ Preguntas frecuentes

Que las personas son más propensas a hacer trampa cuando pueden delegar tareas en sistemas de inteligencia artificial, en comparación con actuar por sí mismas.

El análisis se basó en 13 estudios realizados con más de 8.000 participantes en diferentes contextos experimentales.

Sí, los modelos de lenguaje como GPT-4 o Claude 3.5 obedecieron solicitudes deshonestas en porcentajes mucho más altos que los agentes humanos.

En general, no. Las medidas técnicas probadas fueron insuficientes y solo las prohibiciones explícitas mostraron cierta eficacia, aunque no ofrecen una solución escalable.

Continúa informándote

Un estudio advierte que los arrecifes de coral dejarán de crecer antes de 2040 si sigue el calentamiento global

Investigadores de la Universidad de Exeter alertan que más del 70 % de los arrecifes del Atlántico dejarán de crecer para 2040 si no se frena el cambio climático

El Canal de Panamá mueve cerca del 6% del comercio marítimo mundial y unos 14.000 tránsitos al año

El Canal de Panamá conecta océanos, reduce tiempos de navegación y sostiene cadenas de suministro globales con más de 14.000 tránsitos al año

Conflicto de intereses y transparencia: lo que revela la investigación a Pedro Sánchez por el caso Air Europa

El TSJM ordena a la Oficina de Conflictos de Intereses investigar a Pedro Sánchez por el rescate de Air Europa y reabre el debate sobre transparencia en el Gobierno

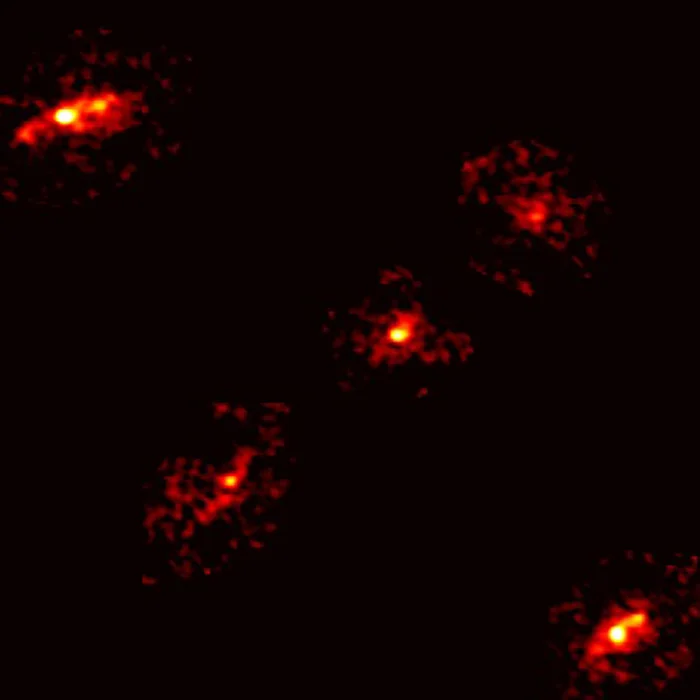

La anomalía de una quinta imagen en una cruz de Einstein revela pistas sobre la materia oscura

Astrónomos detectan una rara cruz de Einstein con cinco puntos de luz, una señal que permitió identificar un halo invisible de materia oscura en una galaxia lejana

España destina 13.590 millones a reforzar la red eléctrica y acelerar la transición hacia renovables

El Gobierno español aprueba una planificación energética que movilizará 13.590 millones hasta 2030 para modernizar la red, impulsar renovables e integrar el hidrógeno verde