La IA no se pone de acuerdo: modelos de OpenAI, Google y DeepSeek difieren en identificar mensajes de odio

Las conclusiones de un estudio de la Universidad de Pensilvania muestran inconsistencias entre los sistemas de moderación de contenido, con riesgos para comunidades vulnerables

3 min lectura

Un nuevo estudio de la Escuela de Comunicación Annenberg de la Universidad de Pensilvania reveló que los modelos de inteligencia artificial de OpenAI, Google y DeepSeek clasifican de manera muy distinta los mensajes de odio en línea. La investigación analizó 1,3 millones de frases y detectó contradicciones significativas en cómo los sistemas evalúan expresiones idénticas.

Los investigadores Neil Fasching y Yphtach Lelkes advierten que estas diferencias generan un problema crítico, los usuarios quedan expuestos a una moderación desigual, donde un comentario puede ser bloqueado en una plataforma y pasar inadvertido en otra. “Las empresas tecnológicas privadas se han convertido en los árbitros de facto del discurso digital, pero lo hacen sin un estándar común”, señalaron.

El análisis incluyó siete modelos, dos de OpenAI, dos de Mistral, Claude 3.5 Sonnet, DeepSeek V3 y la API de Google Perspective. La metodología abarcó afirmaciones que mencionaban a 125 grupos demográficos, desde género y raza hasta educación y clase social, utilizando tanto términos neutrales como insultos explícitos.

Uno de los hallazgos más relevantes es que los sistemas coinciden más al evaluar ataques contra grupos tradicionalmente protegidos, como la orientación sexual o la religión, pero muestran grandes discrepancias cuando se trata de sectores menos visibles, como la clase económica o los intereses personales.

Los expertos también comprobaron que algunos modelos son internamente más consistentes que otros. Mientras unos detectan patrones similares en frases parecidas, otros arrojan resultados contradictorios, lo que refleja diferencias en el diseño y en la prioridad entre rigor y flexibilidad.

La investigación mostró además que los sistemas tratan de manera desigual los mensajes positivos o neutros que contienen insultos en contextos no ofensivos. Claude 3.5 Sonnet y Mistral tienden a marcarlos como dañinos de forma automática, mientras que OpenAI y Google priorizan el contexto, permitiendo que expresiones irónicas o resignificadas no sean etiquetadas como odio.

Para Lelkes, profesor asociado de Annenberg, estas inconsistencias pueden erosionar la confianza del público en las plataformas. “Si la misma frase es considerada discurso de odio en un sitio y no en otro, los usuarios perciben sesgo y arbitrariedad en las reglas de moderación”, advirtió.

El informe también advierte sobre consecuencias más amplias, una detección desigual puede dejar a comunidades enteras más expuestas a la hostilidad digital. “Algunas poblaciones se encuentran más protegidas que otras, no porque reciban menos ataques, sino porque los modelos no reaccionan de manera uniforme”, dijo Fasching.

Los autores señalan que la falta de estándares comunes en la industria dificulta la creación de un marco de referencia global. Hasta ahora, cada empresa diseña sus propios filtros, lo que provoca un mosaico fragmentado en la regulación del discurso en línea.

El trabajo, publicado en Findings of the Association for Computational Linguistics, constituye el primer análisis comparativo a gran escala de sistemas de moderación con IA. Los investigadores esperan que sirva para abrir un debate público sobre la necesidad de mayor transparencia y de marcos regulatorios claros.

En un contexto en el que el discurso de odio online alimenta la polarización política y afecta la salud mental, los expertos concluyen que la consistencia en la moderación no es solo un asunto técnico, sino un desafío democrático que definirá cómo se gestiona el espacio digital en los próximos años.

Fuente: ACL Anthology

❓ Preguntas frecuentes

Mostró que los sistemas de OpenAI, Google y DeepSeek clasifican de forma diferente el mismo contenido, generando inconsistencias en la moderación.

Siete en total, dos de OpenAI, dos de Mistral, Claude 3.5 Sonnet, DeepSeek V3 y la API de Google Perspective.

En los relacionados con clase social, educación e intereses personales, mientras que hubo más coincidencia en temas de género, raza y orientación sexual.

En Findings of the Association for Computational Linguistics, con el apoyo de la Escuela de Comunicación Annenberg de la Universidad de Pensilvania.

Continúa informándote

Científicos crean sangre artificial que transporta oxígeno mejor que los glóbulos rojos naturales

ErythroMer, un desarrollo financiado por la DARPA y universidades de EE. UU., promete revolucionar la medicina de emergencia al ofrecer sangre artificial estable y lista para usar en cualquier lugar

Las hormigas isleñas muestran un colapso poblacional: la ONU alerta sobre un “apocalipsis de insectos”

Un estudio genómico revela que el 79% de las especies endémicas de hormigas en Fiyi están en declive, lo que refleja la vulnerabilidad de la biodiversidad insular

Microsoft apuesta por la energía nuclear y se une a la Asociación Nuclear Mundial

Microsoft se incorpora a la Asociación Nuclear Mundial para impulsar reactores avanzados y garantizar energía libre de carbono a sus centros de datos

Resolución de la ONU condena ataques de Hamás e Israel y exige pasos hacia la solución de dos Estados

La Asamblea General de la ONU aprueba por amplia mayoría una declaración que respalda la solución de dos Estados y condena a Hamás e Israel por la guerra en Gaza

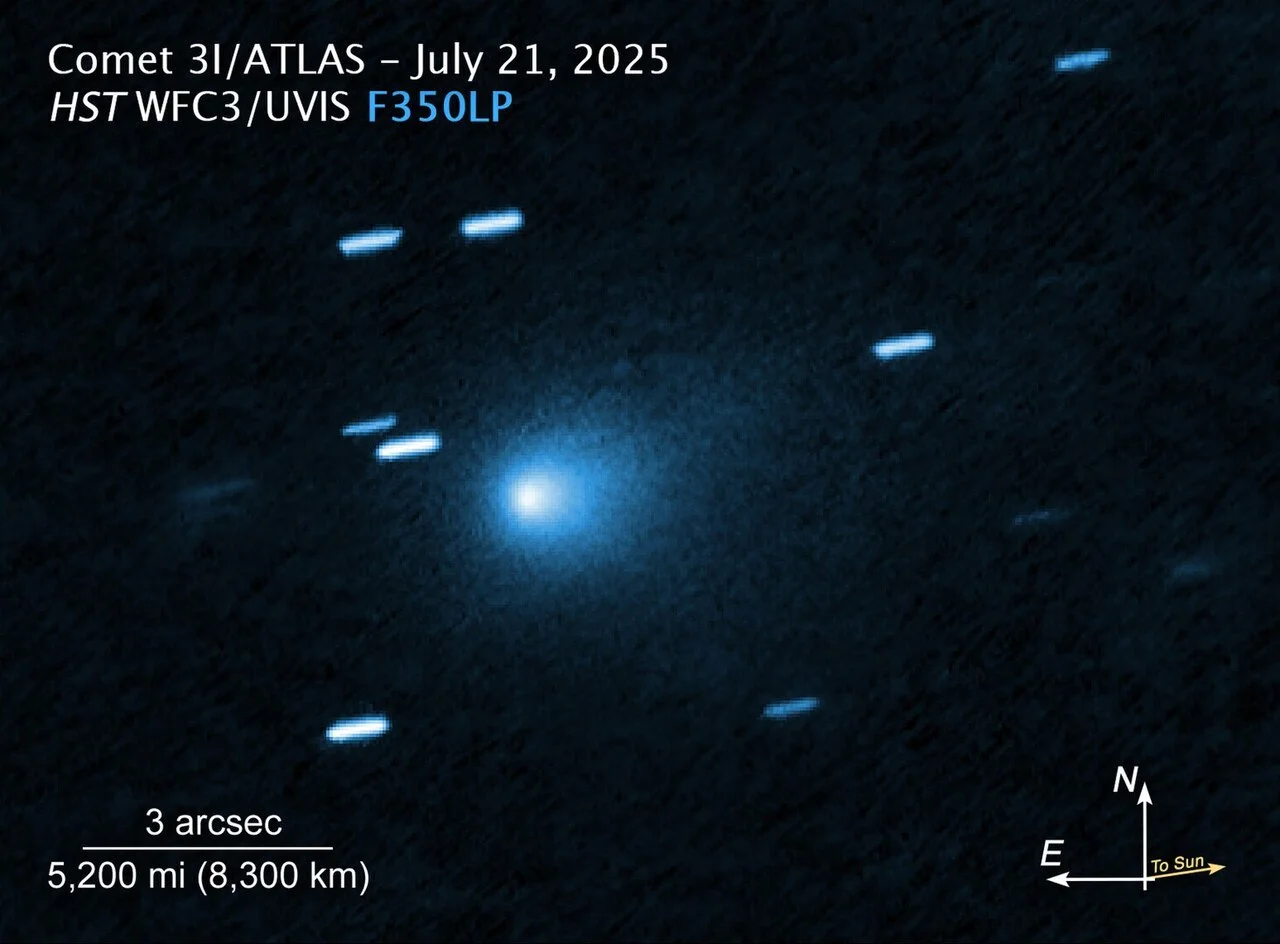

Las primeras imágenes de 3I/ATLAS ayudan a entender cómo evolucionan los cometas en sistemas estelares distintos al nuestro

Las observaciones del objeto interestelar 3I/ATLAS revelan actividad temprana y aportan pistas únicas sobre la composición de cometas formados en otros sistemas solares