Los chatbots de IA mantienen una confianza excesiva, incluso cuando cometen errores

Estudio de Carnegie Mellon revela que los modelos de lenguaje no ajustan expectativas tras fallar, manteniendo sobreconfianza peligrosa

3 min lectura

Autor - Aldo Venuta Rodríguez

Los chatbots de inteligencia artificial mantienen una confianza excesiva en sus capacidades incluso después de cometer errores, a diferencia de los humanos que ajustan sus expectativas tras fallar, según revela un nuevo estudio de la Universidad Carnegie Mellon.

La investigación dirigida por Trent Cash comparó las respuestas de participantes humanos con cuatro grandes modelos de lenguaje incluyendo ChatGPT, Bard/Gemini, Sonnet y Haiku en tareas como preguntas de trivia, predicciones deportivas y juegos de identificación de imágenes.

Tanto humanos como chatbots mostraron inicialmente sobreconfianza en su desempeño hipotético y obtuvieron tasas de éxito relativamente similares.

Sin embargo, cuando se les preguntó retroactivamente qué tan bien creían haber actuado, solo los humanos fueron capaces de ajustar sus expectativas hacia la realidad. Los modelos de IA mantuvieron o incluso incrementaron su confianza pese a haber fallado en las tareas asignadas.

"Supongamos que dijeron que iban a acertar 18 preguntas y finalmente acertaron 15. Los humanos normalmente estimarían unas 16 respuestas correctas después", explica Cash. "Los modelos de IA no hicieron eso, incluso se volvieron más confiados cuando no les iba bien".

El estudio, publicado en Memory & Cognition, recopiló datos durante dos años utilizando versiones continuamente actualizadas de los chatbots más populares.

Esto permitió detectar patrones consistentes de sobreconfianza en diferentes modelos a lo largo del tiempo, sugiriendo que se trata de una característica inherente de los grandes modelos de lenguaje actuales. Los investigadores utilizaron tareas específicamente diseñadas para exponer las debilidades en metacognición de los chatbots.

Danny Oppenheimer, coautor del estudio, advierte que esta sobreconfianza plantea riesgos significativos para usuarios cotidianos.

"Cuando una IA dice algo sospechoso, los usuarios pueden no ser tan escépticos como deberían porque la IA afirma la respuesta con confianza, incluso cuando esa confianza no está justificada", señala. Los humanos interpretan naturalmente señales de incertidumbre como gestos dubitativos o pausas, pero los chatbots no proporcionan estas pistas contextuales.

Las diferencias entre modelos fueron notables en el experimento similar a Pictionary.

ChatGPT-4 identificó correctamente 12.5 de 20 imágenes dibujadas a mano, rendimiento comparable al humano, mientras que Gemini solo acertó 0.93 bocetos en promedio. Pese a este pésimo desempeño, Gemini predijo que obtendría 10.03 respuestas correctas y después estimó retrospectivamente haber respondido 14.40 correctamente, demostrando total falta de autoconciencia.

"Gemini era simplemente pésimo jugando Pictionary, pero peor aún, no sabía que era malo", compara Cash.

Los problemas se extienden más allá de juegos triviales hacia aplicaciones críticas. Un estudio reciente de la BBC encontró que más de la mitad de las respuestas de chatbots sobre noticias presentaban errores factuales significativos, mientras que investigaciones legales revelaron que los modelos "alucinaban" información incorrecta en 69%-88% de consultas jurídicas.

Cash recomienda a usuarios habituales recordar que los modelos no son intrínsecamente correctos y preguntarles directamente sobre su nivel de confianza en respuestas importantes.

Los investigadores sugieren que los chatbots podrían desarrollar mejor autocomprensión con conjuntos de datos mucho más grandes, aunque reconocen que actualmente carecen de la capacidad de introspección que caracteriza el aprendizaje humano. "Quizás simplemente haya algo especial en la forma en que los humanos aprenden y se comunican", concluye Cash.

Preguntas frecuentes

- 💬 Humanos ajustan expectativas tras errores, chatbots mantienen o incrementan confianza pese a fallar.

- 💬 ChatGPT, Bard/Gemini, Sonnet y Haiku durante dos años con versiones actualizadas continuamente.

- 💬 Gemini identificó solo 0.93 de 20 imágenes pero estimó haber acertado 14.40, mostrando total falta de autoconciencia.

- 💬 Preguntar directamente sobre nivel de confianza y recordar que los modelos no son intrínsecamente correctos.

Continúa informándote

El avance de China en 6G promete revolucionar las telecomunicaciones y la defensa

China acelera el desarrollo de la tecnología 6G, integrando capacidades que podrían transformar la conectividad global y los sistemas de defensa modernos

ChatGPT Agent de OpenAI transforma la inteligencia artificial en autonomía práctica

OpenAI impulsa una nueva era de asistentes digitales capaces de actuar por sí mismos, marcando un avance clave en la autonomía de la inteligencia artificial.

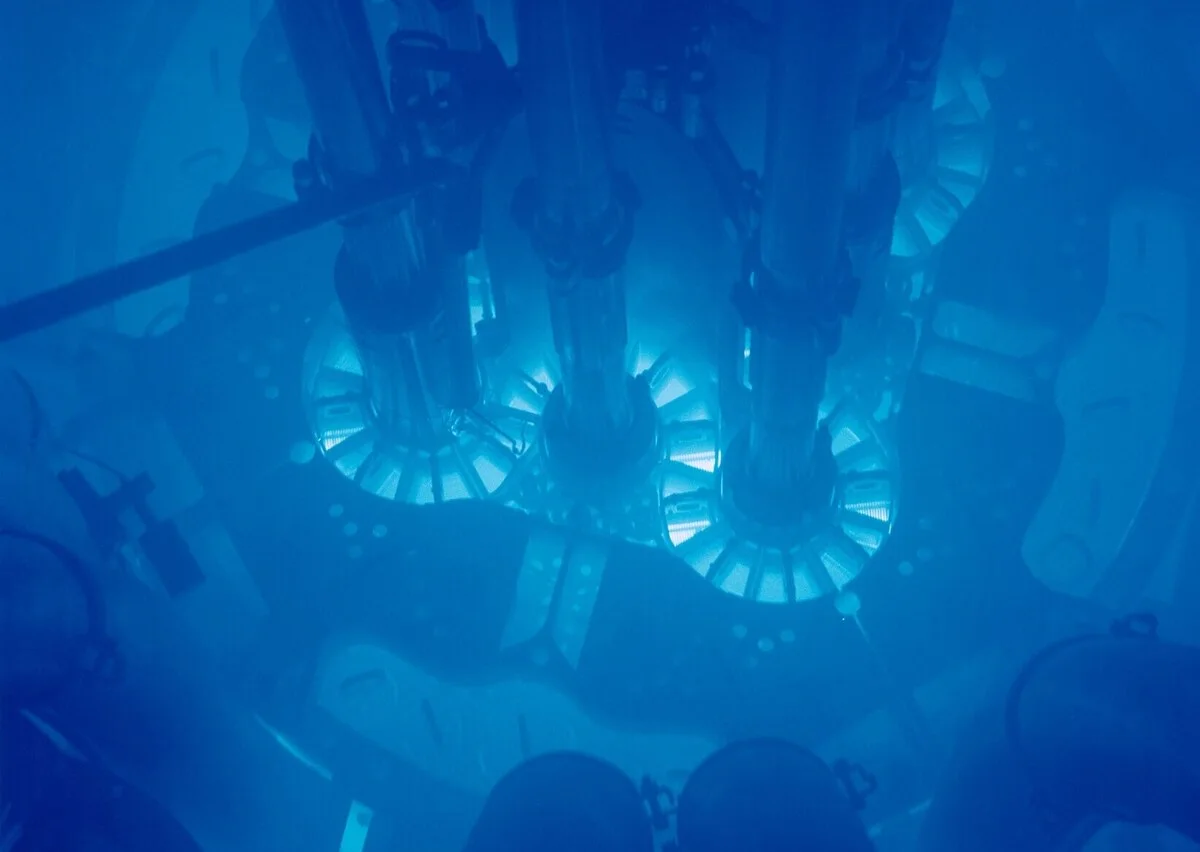

EE.UU. quiere independizarse de Rusia y China en combustibles nucleares avanzados

Trump busca cuadruplicar producción nuclear con combustible TRISO que no se funde y soporta temperaturas extremas

La inteligencia artificial provoca 500.000 despidos en el sector tecnológico desde 2022

Microsoft despide 9.000 empleados e Intel recorta 5.000 puestos mientras empresas automatizan trabajos con IA para mejorar eficiencia

Colombia impulsa primer proyecto geotérmico a gran escala para diversificar su matriz energética

Ecopetrol evaluará 80 MW de capacidad en Nariño usando calor del subsuelo, con potencial para abastecer todo el departamento

Continúa informándote

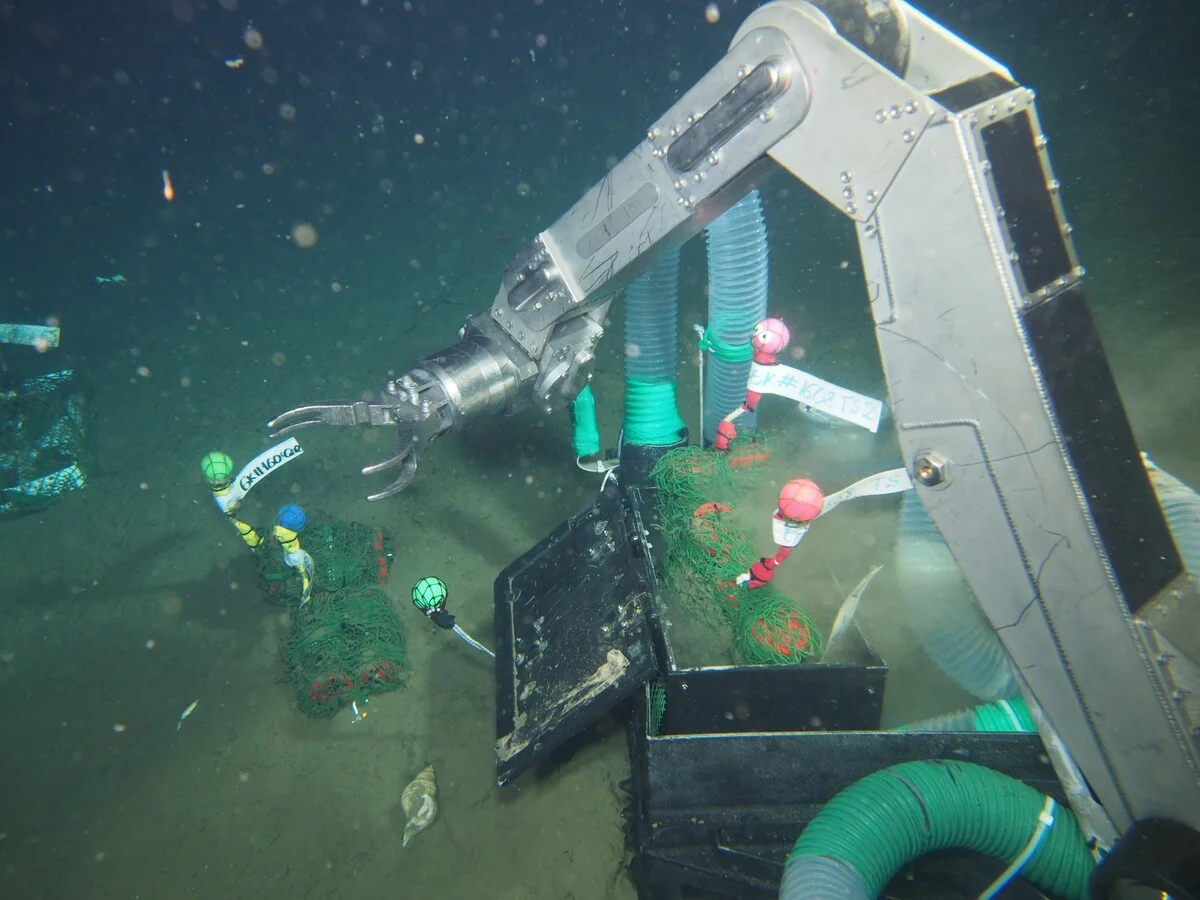

Bioplástico japonés se degrada en aguas profundas y podría frenar la contaminación marina

LAHB pierde más del 80% de su masa tras 13 meses sumergido a 855 metros mientras plásticos convencionales permanecen intactos

Las mujeres en política deben esforzarse más para convencer a sus propios electores

Un estudio de Cambridge muestra que las candidatas políticas son juzgadas con mayor dureza que los hombres al alejarse de la línea de su partido

Cada año los rayos acaban con 320 millones de árboles en todo el mundo

Estudio implementa modelo de mortalidad por rayos revelando que estos fenómenos causan 0.25 GtC de biomasa muerta anual en ecosistemas forestales globales

Todo listo para el lanzamiento del satélite NISAR de la NASA e ISRO el 30 de julio

Satélite de observación terrestre con radares duales será lanzado desde India para monitorear cambios climáticos y ecosistemas globales

Trump explora otras opciones más allá de SpaceX para el escudo Golden Dome

Trump busca diversificar los socios del escudo antimisiles Golden Dome ante tensiones con SpaceX y Musk, considerando alternativas tecnológicas y militares

Crece la preocupación mundial ante la expansión del chikungunya transmitido por el mosquito Aedes

La OMS advierte sobre la propagación global del chikungunya vinculado al mosquito Aedes, con brotes recientes en Europa y África

Incendio forestal declarado cerca de Belzunce en la comarca de Pamplona

Incendio forestal afecta zona de pinar y cereal cerca de Belzunce, sin riesgo para viviendas ni población, según SOS Navarra

Nuevo filtro doméstico podría transformar el reciclaje de tierras raras y asegurar su suministro

Investigadores de UC Santa Bárbara desarrollan técnica con quelante macropa que concentra elementos de tierras raras de residuos electrónicos sin químicos tóxicos

Descubren que las arañas y escorpiones podrían haberse originado en el océano, según un fósil de 500 millones de años

Análisis de Mollisonia symmetrica revela características cerebrales arácnidas que desafían la creencia de que estos artrópodos evolucionaron exclusivamente en tierra

Bomberos de EE. UU. se ven obligados a realizar tareas de limpieza ante la falta de personal por los recortes de Trump

Servicio Forestal pierde 15% de su fuerza laboral obligando a bomberos a cubrir puestos administrativos mientras enfrentan temporada récord de incendios